On considère le système dynamique constitué

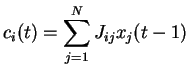

par le jeu de ![]() équations couplées (2.1):

équations couplées (2.1):

C'est, on le voit, un modèle à temps discret.

Des intervalles de temps unitaires séparent la mise à jour des états.

Ces intervalles peuvent être considéré comme des délais de

transmission synaptique, réduits à leur expression la plus simple.

La mise a jour étant effectuée en parallèle,

on a à chaque mise à jour une multiplication de la matrice des

poids

![]() par le vecteur d'états

par le vecteur d'états

![]() auquel on soustrait le vecteur des seuils

auquel on soustrait le vecteur des seuils

![]() .

Le système admet donc comme écriture matricielle :

.

Le système admet donc comme écriture matricielle :

La fonction de transfert ![]() est traditionnellement une fonction sigmoïdale, à valeurs sur ]-1,1[ ou ]0,1[.

Une fonction de transfert à valeurs sur ]-1,1[ est en général considérée comme moins plausible biologiquement dans la mesure où le signe du produit

est traditionnellement une fonction sigmoïdale, à valeurs sur ]-1,1[ ou ]0,1[.

Une fonction de transfert à valeurs sur ]-1,1[ est en général considérée comme moins plausible biologiquement dans la mesure où le signe du produit

![]() ne dépend pas uniquement du signe du lien synaptique, et ne permet pas de définir des liens excitateurs ou inhibiteurs.

La plupart des études numériques porteront sur un système dont la fonction de transfert prend ses valeurs sur ]0,1[.

Le choix de cette fonction de transfert n'est pas fondamental.

On choisit de la faire dépendre du paramètre

ne dépend pas uniquement du signe du lien synaptique, et ne permet pas de définir des liens excitateurs ou inhibiteurs.

La plupart des études numériques porteront sur un système dont la fonction de transfert prend ses valeurs sur ]0,1[.

Le choix de cette fonction de transfert n'est pas fondamental.

On choisit de la faire dépendre du paramètre ![]() ,

qui conditionne la forme de la fonction de transfert (voir figure 2.1) et en particulier la valeur de la dérivée en zéro.

Cette valeur de la dérivée en zéro constitue le gain.

Intuitivement, le gain donne une approximation du taux d'amplification

d'un signal centré.

La fonction de transfert qui sera utilisée par la suite est la fonction

,

qui conditionne la forme de la fonction de transfert (voir figure 2.1) et en particulier la valeur de la dérivée en zéro.

Cette valeur de la dérivée en zéro constitue le gain.

Intuitivement, le gain donne une approximation du taux d'amplification

d'un signal centré.

La fonction de transfert qui sera utilisée par la suite est la fonction

![\includegraphics[]{ftrans_g2.eps}](img345.png)

![\includegraphics[]{ftrans_g4.eps}](img346.png)

![\includegraphics[]{ftrans_g6.eps}](img347.png) |

Chacune des ![]() équations de (2.1) décrit la loi de mise à jour de

l'état d'activation (ou l'activation)

équations de (2.1) décrit la loi de mise à jour de

l'état d'activation (ou l'activation) ![]() de l'unité

neuronale indexée par l'indice

de l'unité

neuronale indexée par l'indice ![]() .

À chaque instant, l'activation du neurone au temps

.

À chaque instant, l'activation du neurone au temps ![]() est conditionné

par l'activation de tous les neurones à l'instant précédent.

est conditionné

par l'activation de tous les neurones à l'instant précédent.

On appelle dimension spatiale la dimension sur laquelle évolue l'indice ![]() et dimension temporelle la dimension sur laquelle évolue l'indice

et dimension temporelle la dimension sur laquelle évolue l'indice ![]() .

La moyenne spatiale désigne la moyenne sur tous les neurones à un instant donné, et la moyenne temporelle désigne la valeur moyenne d'un signal émis par un seul neurone.

Notons au passage qu'il existe une autre dimension nécessaire pour les approches plus théoriques, appelée la dimension de l'aléa. Cette dimension porte sur l'ensemble des tirages aléatoires possibles selon les paramètres du modèle.

.

La moyenne spatiale désigne la moyenne sur tous les neurones à un instant donné, et la moyenne temporelle désigne la valeur moyenne d'un signal émis par un seul neurone.

Notons au passage qu'il existe une autre dimension nécessaire pour les approches plus théoriques, appelée la dimension de l'aléa. Cette dimension porte sur l'ensemble des tirages aléatoires possibles selon les paramètres du modèle.

On distingue habituellement deux grandeurs qui permettent de décrire

de façon plus détaillée les caractéristiques du neurone à

l'instant ![]() :

:

En fin de compte, on décrit habituellement le système par le jeu d'équations couplées (2.2).

Du point de vue de l'interprétation biologique, on considère parfois que, dans le cas d'une fonction de transfert à valeurs sur ![]() , l'activation

, l'activation ![]() représente le taux de décharge du neurone sur l'intervalle

représente le taux de décharge du neurone sur l'intervalle ![]() , la valeur 1 étant rapportée à la fréquence de décharge maximale.

C'est l'interprétation traditionnelle des fonctions de transfert à états continus.

, la valeur 1 étant rapportée à la fréquence de décharge maximale.

C'est l'interprétation traditionnelle des fonctions de transfert à états continus.

Une autre interprétation consiste à considérer la valeur de ![]() comme une probabilité de décharge sur l'intervalle

comme une probabilité de décharge sur l'intervalle ![]() .

Cette interprétation peut être mise en

.

Cette interprétation peut être mise en ![]() uvre numériquement, auquel cas l'activation au temps

uvre numériquement, auquel cas l'activation au temps ![]() dépend d'une probabilité et prend des valeurs binaires (un spike/pas de spike).

À grande taille, ce modèle est équivalent à un modèle à états continus dont le champ local est bruité par un bruit gaussien

2.1.

Un tel modèle est présenté page

dépend d'une probabilité et prend des valeurs binaires (un spike/pas de spike).

À grande taille, ce modèle est équivalent à un modèle à états continus dont le champ local est bruité par un bruit gaussien

2.1.

Un tel modèle est présenté page ![]() .

.

L'approche que nous adopterons dans le cadre de cette thèse est sensiblement différente et sera justifiée plus loin. On établira un critère d'activité du neurone fondé sur l'écart-type du signal d'activation. Dans ce cadre, les neurones dont l'écart-type est faible sont considérés comme inactifs. Cela vaut pour les neurones dont le signal est saturé par la fonction de transfert.

La taille du réseau (nombre d'unités) est ![]() . La matrice

. La matrice ![]() , de taille

, de taille

![]() , décrit les couplages du réseau.

L'espace des paramètres est de grande dimension, et, de ce fait, des prédictions sur le comportement asymptotique sont très difficiles.

On a donc fixé certaines règles pour réduire l'espace des paramètres.

Les poids sont des variables gaussiennes indépendantes et de moyenne

, décrit les couplages du réseau.

L'espace des paramètres est de grande dimension, et, de ce fait, des prédictions sur le comportement asymptotique sont très difficiles.

On a donc fixé certaines règles pour réduire l'espace des paramètres.

Les poids sont des variables gaussiennes indépendantes et de moyenne

![]() et de variance var(

et de variance var(![]() ) =

) =

![]() , où

, où ![]() est la taille du réseau et

est la taille du réseau et ![]() l'écart-type de référence.

On notera que la loi qui définit les tirages des poids synaptiques a été choisie de telle sorte que l'espérance et la variance de la somme des poids afférents

l'écart-type de référence.

On notera que la loi qui définit les tirages des poids synaptiques a été choisie de telle sorte que l'espérance et la variance de la somme des poids afférents

![]() ne dépendent pas de

ne dépendent pas de ![]() , et valent respectivement

, et valent respectivement ![]() et

et

![]() .

On impose de plus

.

On impose de plus ![]() (les neurones ne rebouclent pas sur eux-mêmes).

Les seuils sont gaussiens, de moyenne

(les neurones ne rebouclent pas sur eux-mêmes).

Les seuils sont gaussiens, de moyenne

![]() et de variance

et de variance

![]() .

.

Les variables ![]() ,

, ![]() ,

, ![]() ,

,

![]() ,

,

![]() constituent les paramètres macroscopiques du système.

Les valeurs précises des

constituent les paramètres macroscopiques du système.

Les valeurs précises des ![]() et des

et des ![]() issues d'un tirage aléatoire constituent les paramètres microscopiques du système.

issues d'un tirage aléatoire constituent les paramètres microscopiques du système.

Plusieurs remarques en découlent :